SEO Terugblik 2025: Het jaar waarin zoeken definitief veranderde

OMA B.V.

Dieselstraat 1B

6716 BC Ede

Kvk: 83301852

Robots.txt is een klein maar erg belangrijk bestand dat met name door developers en online marketeers wordt gebruikt. Met een robots.txt vertel je zoekmachines welke pagina’s van een website wel of niet gecrawld mogen worden. Dat klinkt misschien wat technisch, maar de werking is eigenlijk heel eenvoudig. In deze blog leg ik je uit wat robots.txt precies is, hoe het werkt, en waarom het ook voor jouw website belangrijk is!

Een robots.txt-bestand stuurt instructies naar zoekmachinebots, zoals die van Google. De bots van zoekmachines crawlen je website om te bepalen welke pagina’s ze in de zoekresultaten moeten weergeven. Via de robots.txt geef je de bots specifieke richtlijnen. Zie het robots.txt bestand als een soort gastheer, die weet ook precies waar iedereen moet wezen. De robots.txt is de gastheer van je website, hij verteld de bots welke pagina’s ze wel of niet mogen bezoeken (crawlen).

Het bestand zelf is een tekstbestand dat zich in de root van je website bevindt. Deze kan je voor iedere site vinden door achter het domein /robots.txt te zetten. (bijvoorbeeld: onlinemarketingagency.nl/robots.txt). Belangrijk, het kan zijn dat een website geen robots.txt file heeft, dan kan je die ook niet vinden. Het bevat regels die bots vertellen waar ze wel en niet mogen komen. De volgende instructies kunnen worden herkend in de robots.txt

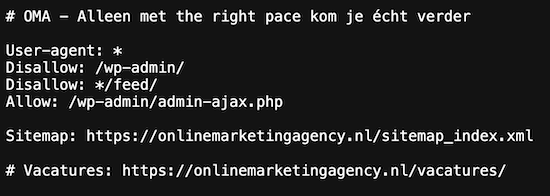

Het voorbeeld van OMA:

Let op: onderaan deze blog staan nog meer voorbeelden

Bij het gebruik van robots.txt-bestanden op subdomeinen is het belangrijk te weten dat elk subdomein een eigen bestand nodig heeft. De regels op bijvoorbeeld www.domein.nl/robots.txt gelden niet voor een subdomein zoals blog.domein.nl. Zorg ervoor dat de instellingen per subdomein aansluiten bij wat je wilt crawlen of blokkeren. Voor een test- of staging-omgevingen kun je met een disallow zoekmachines blokkeren, maar voor meer zekerheid is het beter om IP-whitelisting of wachtwoordbeveiliging te gebruiken, omdat robots.txt geen beveiligingsmaatregel is.

Controleer in Google Search Console of subdomeinen correct worden gecrawld en voeg aparte properties toe voor monitoring. Gebruik daarnaast per subdomein een eigen sitemap, vermeld deze in de robots.txt, en test de instellingen regelmatig.

Een goed ingesteld robots.txt-bestand helpt je de controle te houden over wat er uiteindelijk wel en niet wordt gecrawld. Het is vanwege het crawlbudget belangrijk om bots richtlijnen mee te geven welke pagina’s wel of niet gecrawld mogen worden. Laat zoekmachines zich richten op de belangrijkste pagina’s van je website die geïndexeerd mogen [lees: moeten] worden.

Stel dat je een pagina hebt die voor klanten belangrijk is, maar niet voor zoekmachines. Dan hebben we het over accountpagina’s, bijvoorbeeld van webshops. Met robots.txt kun je eenvoudig aangeven dat deze pagina’s niet gecrawld mogen worden. Het voordeel? Gebruikers merken niets en je crawlbudget gaat er niet aan verloren.

Verder zorgt een goed robots.txt-bestand bij het beheren van je crawlbudget. Zoekmachines hebben namelijk maar een beperkt aantal pagina’s dat ze per dag crawlen. Door onbelangrijke pagina’s uit te sluiten, zorg je ervoor dat de bots zich richten op de content die er echt toe doet. Een goed geconfigureerde robots.txt zorgt voor een efficiënter gebruik van het crawlbudget en kan de vindbaarheid van je belangrijkste pagina’s verbeteren.

Let op: een verkeerde configuratie, waarbij per ongeluk waardevolle content wordt geblokkeerd van crawlen, kan leiden tot minder indexatie en daarmee een negatieve impact op je SEO.

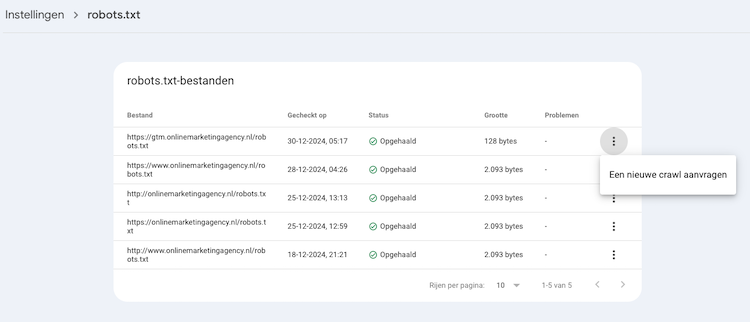

First things first, blokkeer nooit je belangrijke pagina’s van crawlen! Het is belangrijk voor de uiteindelijke prestaties van je website dat je geen pagina’s blokkeert die je juist wél in de zoekresultaten wilt hebben. Controleer daarom altijd je robots.txt-bestand zorgvuldig. Maak daarnaast ook gebruik van de testtool van Google in Google Search Console (GSC). Binnen GSC vind je een robots.txt-tester waarmee je kunt zien of je bestand goed werkt. Je vindt deze op al volgt terug:

Google Search Console: instellingen > robots.txt

Klik op de drie puntjes bij het robots.txt bestand waar je de veranderingen hebt aangebracht en dan op de (enige) optie ‘Een nieuwe crawl aanvragen’.

Wees voorzichtig met belangrijke informatie uitsluiten via de robots.txt. Hoewel je met robots.txt pagina’s kunt blokkeren voor bots, zijn deze nog steeds toegankelijk als iemand de URL direct invoert. Als iemand je robots.txt bestand opent kan hij of zij zien staan welke pagina’s een disallow hebben. Gebruik dus nooit robots.txt voor gevoelige informatie, maar maak dan gebruik van een htaccess vergrendeling.

Let op: de robots.txt is hoofdlettergevoelig, alles moet in kleine letter staan.

Al met al is het robots.txt-bestand een eenvoudige maar effectieve manier om de bots van zoekmachines te sturen. Door de juiste pagina’s uit te sluiten van crawling, kun je de focus leggen op de content die echt van belang is voor SEO. Heb je het bestand al goed ingesteld? Zo niet, dan is het een eenvoudige stap die je direct kunt nemen om je SEO te verbeteren!

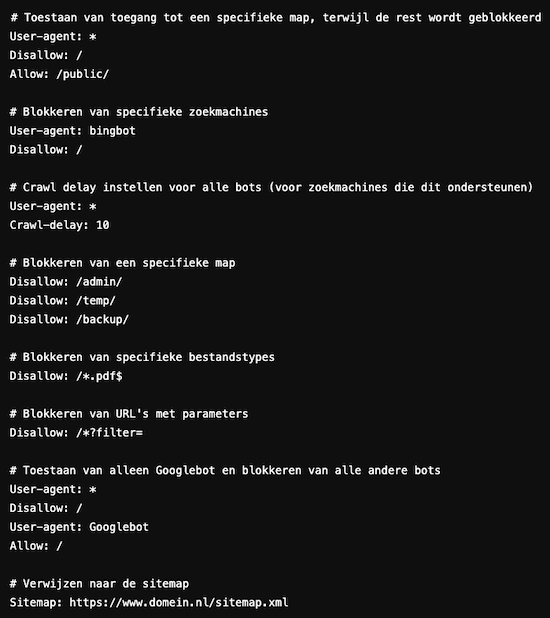

Om je op weg te helpen heb ik wat voorbeelden op een rijtje gezet die je kan overnemen voor je eigen robots.txt bestand.

Voorkom dat zoekmachines een bepaalde map op je website crawlen, zoals een admin-dashboard:

User-agent: *

Disallow: /admin/

Blokkeer een specifieke zoekmachine, zoals Bing, terwijl je andere toestaat:

User-agent: bingbot

Disallow: /

Als je de gehele site hebt geblokkeerd, maar één map toegankelijk wilt maken:

User-agent: *

Disallow: /

Allow: /public/

Vermijd dat zoekmachines bepaalde bestandstypes crawlen, zoals PDF-bestanden:

User-agent: *

Disallow: /*.pdf$

Informeer zoekmachines over de locatie van je sitemap:

User-agent: *

Sitemap: https://www.domein.nl/sitemap.xml

Voorkom dat een specifieke pagina door zoekmachines wordt gecrawld:

User-agent: *

Disallow: /privacy-policy.html

Blokkeer pagina’s met bepaalde URL-parameters, bijvoorbeeld filters of zoekresultaten:

User-agent: *

Disallow: /*?filter=

Sta alleen Googlebot toe en blokkeer alle andere bots:

User-agent: *

Disallow: /

User-agent: Googlebot

Allow: /

Blokkeer meerdere submappen op een website:

User-agent: *

Disallow: /private/

Disallow: /temp/

Disallow: /backup/

Stel een vertraging in voor zoekmachines om overbelasting van je server te voorkomen:

User-agent: *

Crawl-delay: 10

Let op: Niet alle zoekmachines ondersteunen een crawl-delay

Ja en hoe zou een robots.txt bestand eruitzien als de bovenstaande regels erin zouden staan? Terechte vraag! Zou krijg je een beetje een beeld hoe zo’n bestand ingedeeld wordt.

Belangrijk: Dit bestand bevat een mix van algemene en specifieke regels. Controleer altijd of de configuratie aansluit bij je doelstellingen en technische setup.

Een monster van een robots.txt bestand bekijken? Bekijk dan die van The New York Times eens!

Een bestand dat zoekmachines vertelt welke pagina’s wel of niet gecrawld mogen worden.

Blokkeer geen waardevolle pagina’s, gebruik geen robots.txt voor gevoelige info, en controleer regelmatig via Google Search Console.

Je kunt het bestand testen met deze tool of door de URL in een browser te openen en te controleren of de regels correct worden weergegeven.

Sommige bots, zoals ‘kwaadwillende’ crawlers, kunnen de regels in robots.txt negeren en alsnog je website crawlen.

Nee, robots.txt voorkomt alleen crawling.

Geschreven door: Igor van den Ende

Igor is online marketeer bij OMA. Met een zwarte band in karate én digital marketing veegt hij de vloer aan met jouw online concurrentie.