SEO Terugblik 2025: Het jaar waarin zoeken definitief veranderde

OMA B.V.

Dieselstraat 1B

6716 BC Ede

Kvk: 83301852

In deze blog lees je waar je dit rapport vindt. En hoe je de informatie kunt lezen.

Als we het hebben over het crawlen van de website dan bedoelen we dat Google, of een andere zoekmachine, de website verkent. De bots van de zoekmachine – ook wel crawlers genoemd – bekijken de website.

Wij vergelijken dit met een spin die door een web(site) kruipt. De crawler doorzoekt de website volledig om de inhoud te indexeren. Wanneer iemand op een bepaalde term zoekt, worden – uit alle geïndexeerde pagina’s met die term – de meeste relevante pagina’s gekozen en vervolgens aan de bezoeker getoond.

Is jouw website niet goed crawlbaar? Dan worden ook ’je pagina’s niet goed geïndexeerd. En daarom is een website die niet goed gecrawld kan worden ook slechter vindbaar in zoekmachines.

Het crawlstatistieken rapport uit Google Search Console biedt jou veel inzicht in de manier waarop Google jouw website crawlt. Zo kun je bijvoorbeeld in één oogopslag zien wat de statuscodes zijn. Oftewel, de informatie die door de server wordt doorgestuurd naar de browser over de opgevraagde pagina. En zo weet je dus ook welke pagina’s serverfouten hebben en/of niet gevonden kunnen worden.

Maar voordat we in de crawlstatistieken duiken, leggen we je nog even het verschil uit tussen crawlen en indexeren

Tijdens het crawlen gaat de bot van Google langs de sitemap en langs alle URL’s die al een keer gecrawld zijn door Google. De crawler volgt alle externe links op de pagina’s en checkt op die manier of er nieuwe pagina’s zijn en of er informatie gewijzigd is.

Elke indexeerbare pagina die de crawler tegenkomt stuurt de crawler door naar Google Index. Google analyseert de content op die pagina om te begrijpen waar de pagina over gaat.

De URL’s worden dus eerst ontdekt tijdens het crawlen en vervolgens geïnterpreteerd bij het indexeren.

De crawlstatistieken van Google Search Console geven je een duidelijker beeld van hoe de Googlebot jouw website crawlt. Je ziet bijvoorbeeld welke Googlebot de website heeft gecrawld, wat de statuscodes is van de pagina’s op jouw website en welke bestandstypes zijn gecrawld.

Oftewel, de crawlstatistieken laten een schat aan informatie en data zien. Daar houden wij van. En jij ook – want daarmee kun jij de techniek van je website verbeteren.

De crawlstatistieken zijn heel makkelijk terug te vinden in Google Search Console. Log in, kies het domein waar je de crawlstatistieken van wil zien en ga naar instellingen.

Daar vind je het crawlrapport. Zo makkelijk kan het zijn!

Open het rapport en houd deze blog bij de digitale hand om precies te zien wat jij hier allemaal kan terugvinden.

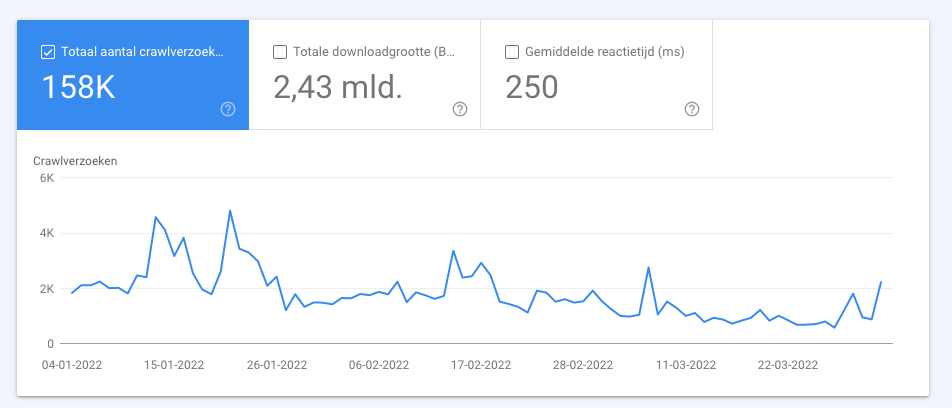

In het crawlrapport vind je verschillende data terug. Bovenaan in het rapport zien we het totaal aantal crawlverzoeken tijdens de geselecteerde periode, het totaal aantal bytes dat gedownload is en de gemiddelde reactietijd van de server.

Daaronder vind je de status van de host. Alle crawlproblemen die tijdens het crawlen van de website naar voren zijn gekomen, worden hier vermeld. Zijn er bijvoorbeeld problemen met de robots.txt of met de sitemap.xml, dan zie je dat hier terug.

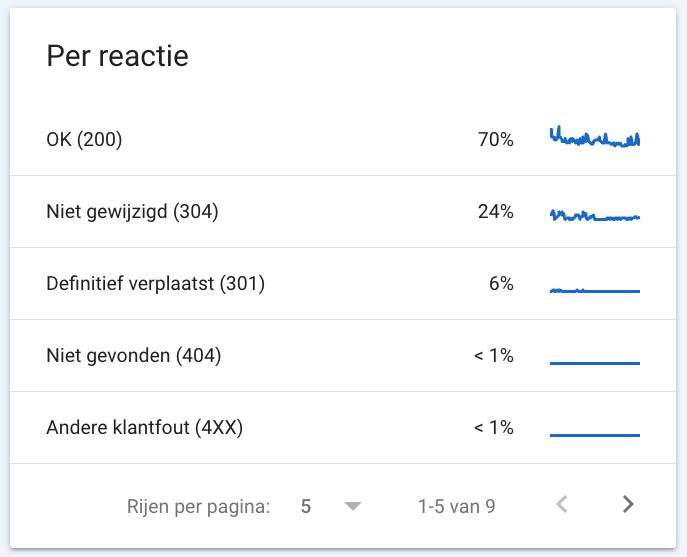

Waar ons SEO-hart sneller van gaat kloppen – tromgeroffel – de uitsplitsingen van de crawlverzoeken.

In het crawlrapport vind je namelijk alle crawlverzoeken uitgesplitst:

In deze uitsplitsing zie je precies tegen welke statuscodes de Googlebot aan is gelopen tijdens het crawlen. Zie je hier een hoop 301’s, 304’s of 404’s terug? Klik dan even door op de code en zie meteen welke URL’s die statuscode hebben.

Meest voorkomende statuscodes:

Zie je bijvoorbeeld een hoop 404’s terug in het crawlrapport? Maak daar dan werk van om te voorkomen dat de Googlebots hier keer op keer crawlbudget in steken.

Dagelijks crawlt Google namelijk een aantal pagina’s op je website. Dat aantal wordt het crawlbudget genoemd en is afhankelijk van bijvoorbeeld de autoriteit van je website. Heb jij zo min mogelijk foutieve statuscodes in het crawlrapport, dan wordt het crawlbudget voornamelijk in 200 pagina’s gestoken. En dat wil je natuurlijk!

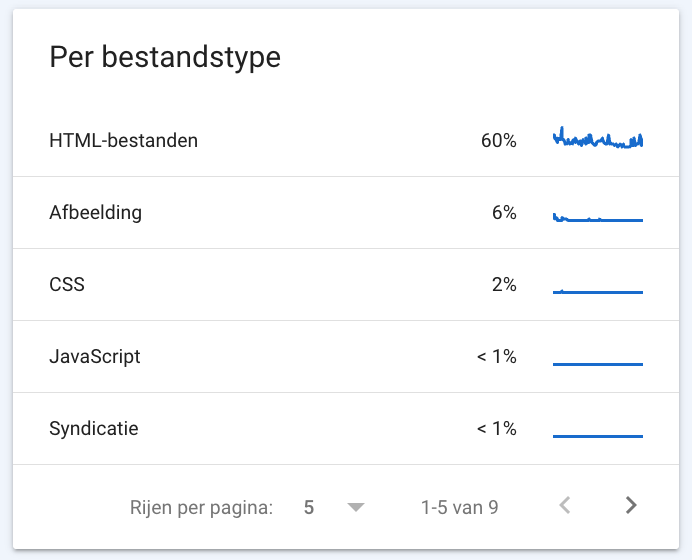

Onder deze uitsplitsing vind je alle type bestanden die Google heeft gedownload. Heeft jouw website een trage reactietijd? Dan kun je hier zien welke bronnen zijn gecrawld. Leest Google bijvoorbeeld kleine afbeeldingen? Dan kun je die uitsluiten van de crawl.

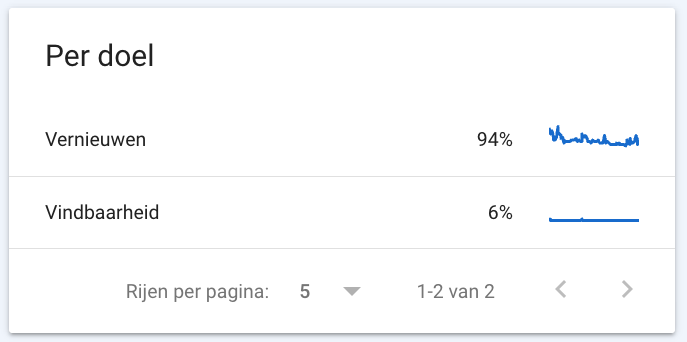

Onder het crawlrapport vind je ook terug wat de verhouding is tussen opnieuw beoordeelde URL’s en voor-het-eerst-gecrawlde URL’s. Onder ‘Vernieuwen’ vind je alle URL’s die al eerder ontdekt zijn door de Googlebot en onder ‘Vindbaarheid’ vind je alle URL’s die voor het eerst worden gevonden door de crawler.

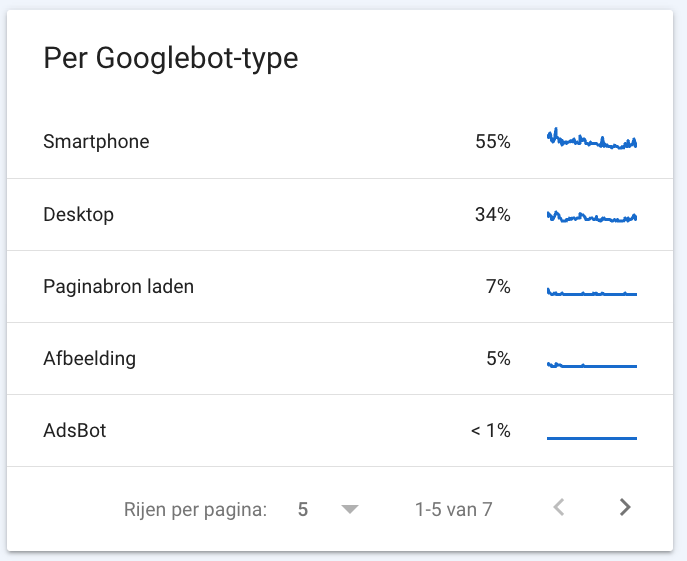

Tot slot worden de crawlverzoeken uitgesplitst per Googlebot. Google gebruikt verschillende bots met verschillende user-agents die om verschillende redenen crawlen en ook verschillend gedrag vertonen. Denk bijvoorbeeld aan een smartphone-bot, een dekstop-bot, een afbeelding-bot, een ads-bot of een store-bot.

De verschillende crawlers simuleren bezoekers via het type user-agent van de bezoeker. De meeste van je crawlverzoeken moeten afkomstig zijn van je primaire crawler. Dat is altijd smartphone of desktop.

Hoe haal je het meeste uit de crawlstatistieken? Dat leggen we je graag uit. Check onze tips hieronder:

Wordt er veel crawlbudget gebruikt voor pagina’s met statuscodes die je liever niet ziet, zoals 404’s of 304’s? Of gaat er veel crawlbudget op aan pagina’s met serverfouten? Dat is zonde! Want daardoor is er minder – of zelfs geen – budget voor andere pagina’s. Los de fouten die je tegenkomt dus op om ervoor te zorgen dat jouw crawlbudget zo efficiënt mogelijk wordt gebruikt.

Hoewel de bots van Google volledig op eigen houtje langskomen, kun je het ze wel een stuk makkelijker maken! En dat is belangrijk. Want hoe makkelijker je website gelezen kan worden door de bots, hoe beter vindbaar jouw website is.

Help de crawlers door pagina’s uit te sluiten in de robots.txt, door nieuwe pagina’s handmatig aan te bieden in Google Search Console en door te zorgen dat je sitemap in orde is.

Laadt jouw website langzaam? Dan doet een crawler er langer over om door de pagina’s van de website heen te bewegen. En dat is zonde, want dan is het web die de crawler maakt dus kleiner dan wanneer de website snel laadt.

Check daarom de laadtijd van jouw website met Google PageSpeed Insights. Is de laadtijd slecht? Pas dan de tips toe die PageSpeed Insights je geeft!

[optin-monster-shortcode id=”mbh1crt7iabrnlnnfvpg”]

Crawlen betekent dat de bots van een zoekmachine een website verkennen. De bots van de zoekmachine – ook wel crawlers genoemd – bekijken de website. Wanneer iemand op een bepaalde term zoekt, worden – uit alle geïndexeerde pagina’s met die term – de meeste relevante pagina’s gekozen en vervolgens aan de bezoeker getoond

In de crawlstatistieken van Google Search Console zie je alle gegevens terug die Google heeft verzameld tijdens het crawlen. De crawlstatistieken geven precies aan welke URL’s gecrawld zijn, wat de statuscode is van die URL’s en welke bestandstypes zijn gecrawld. Zo krijg je meer inzicht in de manier waarop jouw website door Google gelezen wordt.

De crawlstatistieken vind je heel eenvoudig terug in Search Console. Ga naar instellingen en open het rapport onder crawlen. Daar vind je alle informatie die Google heeft verzameld tijdens het crawlen.

Geschreven door: Nicole de Boer

Nicole is Performance Manager bij OMA. Ze brengt je website op smaak met fijne SEO content en hakt je concurrentie in de pan. Lekker en gezond in één.